Rassistische KI: Zoom und Twitter bevorzugen weisse Menschen

Zoom beraubt schwarzen Personen ihrer Köpfe, Twitter ignoriert sie in der mobilen Anwendung gleich ganz: Was hinter dem algorithmischen Rassismus steckt.

Das Wichtigste in Kürze

- KI hat ihre Tücken – diese äussern sich teilweise in Rassendiskriminierung.

- Die Videokonferenz-Software Zoom blendet teilweise Köpfe schwarzer Personen aus.

- Auch Twitter bevorzugt im Post-Feed weisse Gesichter.

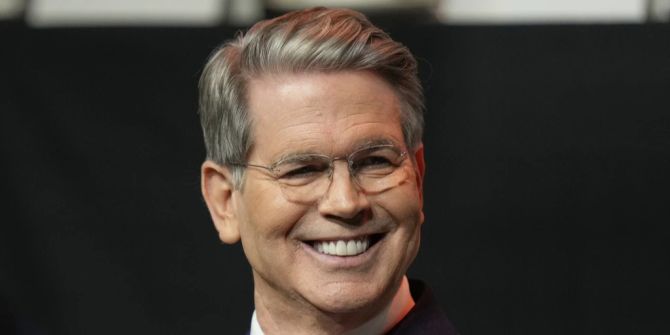

Der kanadische Doktorand Colin Madland staunte nicht schlecht, als an einer Zoom-Videokonferenz plötzlich der Kopf seines schwarzen Kollegen fehlte. Die Software interpretierte dessen Gesicht als zum Hintergrund gehörend und überdeckte dieses darum mit dem von ihm ausgewählten virtuellen Hintergrund.

Madland thematisierte das Problem auf Twitter und postete dazu ein Foto der Konferenz zwischen ihm und seinem Fakultätskollegen. Doch auch hier macht ihm die Software einen Strich durch die Rechnung: In der mobilen Variante von Twitter wird nur das weisse Gesicht Madlands gezeigt. Sein schwarzer Kollege bleibt ignoriert.

Es ist völlig normal, dass Twitter Bilder im überbreiten Format beschneidet. Dies, um diese kompatibel mit der Bildformat-Vorgabe im Feed der Plattform zu machen. Dabei versucht ein Algorithmus nur den relevanten Teil des Fotos dazustellen. Erkennt er darauf ein Gesicht, wird dieses als relevant eingestuft und dafür ein Teil des Hintergrunds weggelassen.

«Rassistische» Algorithmen

Problem: Viele Gesichtserkennungs-Algorithmen haben Mühe mit der Erkennung von dunklen Gesichtern. Das liegt insbesondere daran, dass dort, wo weniger Licht reflektiert wird, Kontraste weniger gut zu erkennen sind. Letztere sind nötig, um Eigenheiten eines Gesichtes zu erkennen.

Sowohl Zoom als auch Twitter haben inzwischen angekündigt, die Angelegenheit unter die Lupe zu nehmen. Der Chief Digital Officer von Twitter reagierte sogar direkt auf Madlands Post: «Ich bin genauso irritiert wie alle anderen. Aber ich bin in einer Position, das Problem zu beheben. Und ich werde das Problem beheben.»

Dass Automatismen zur Gesichtserkennung mit Hinblick auf die Hautfarbe problematisch sein können, ist nichts Neues. So kommen in den USA immer mehr Automatismen zum Einsatz, welche per Überwachungskamera potenzielle Kriminelle erkennen sollen. Wer dunkler Hautfarbe ist, wird von der KI eher mit einem Kriminellen verwechselt, als Menschen mit heller Hautfarbe.