Wie gefährlich wären Deepfakes des Bundesrats?

Eine Schweizer Studie zeigt: Kaum jemand kann noch echte von unechten Videos unterscheiden. Nau.ch hat mit einem der Studienautoren über die Gefahren geredet.

Das Wichtigste in Kürze

- Deepfakes können kaum noch von echten Videos unterschieden werden, zeigt eine Studie.

- Zwar gibt es viele nützliche Anwendungen für die Technologie, aber auch Gefahren.

- Was wäre wenn … ein Deepfake eines Bundesrats verbreitet würde?

Die Technologie ist mittlerweile so gut, dass sowohl Menschen wie auch Spezialsoftware überlistet werden: Deepfakes, mit künstlicher Intelligenz erstellte Videos von real existierenden Personen, denen man beliebige Aussagen in den Mund legen kann. Eine Schweizer Studie zeigt: Die Schweiz ist ungenügend dagegen gewappnet.

Wo liegen die Gefahren und wie sollten wir uns als Gesellschaft darauf vorbereiten? Darüber hat Nau.ch mit dem Co-Autor der Studie, Daniel Vogler, geredet. Vogler ist Forschungsleiter und stellvertretender Direktor am Forschungszentrum Öffentlichkeit und Gesellschaft der Universität Zürich.

Nau.ch: Herr Vogler, es gibt bereits verschiedene Beispiele von Deepfakes von Politikern. Was könnte im Extremfall passieren, wenn jemand ein Deepfake-Video eines Bundesrats verbreitet? Gibt es dann Unruhen und Proteste und verfälschte Abstimmungsresultate?

Daniel Vogler: Es gibt schon Szenarien, gerade auch weil mit KI vieles je länger, je leichter herzustellen ist. Aber so weit sind wir noch nicht. Das Spektrum ist sehr breit: Es gibt auch viele lässige Sachen, die man mit Deepfakes machen kann. Man muss jetzt aber ein Auge drauf haben, wo man die entscheidenden Stellschrauben anziehen kann.

Nau.ch: Nimmt die Bevölkerung die Politiker überhaupt genügend ernst, dass da ein Effekt eintritt? Immerhin gab es letzte Woche ein Video mit einem Nationalrat, der einen bewaffneten Polizisten angriff. Dieses war sogar echt, aber die Bevölkerung blieb dennoch ziemlich gelassen.

Daniel Vogler: Wegen eines einzelnen Videos wird man sicher kein Problem haben. Aber wir haben die Bevölkerung befragt, ob sie die originalen und computergenerierten Personen noch unterscheiden können. Rein optisch geht das heute nicht mehr.

Dann ist da aber noch der Kontext. Ist es plausibel, dass dieser Nationalrat das macht? Dann kann man sagen: Ja, der macht immer wieder kontroverse Dinge.

Es ist allein schon wichtig, dass man weiss: Diese Technologie gibt es, man kann Deepfakes erstellen. In der Schweizer Politik ist das nicht so kritisch. Aber in Krisengebieten wie der Ukraine oder in Gaza sind Deepfakes ein Problem.

Nau.ch: Kann man sagen: Die gute Nachricht ist, dass das Thema Deepfake in der Bevölkerung schon bekannt ist – und immer bekannter wird?

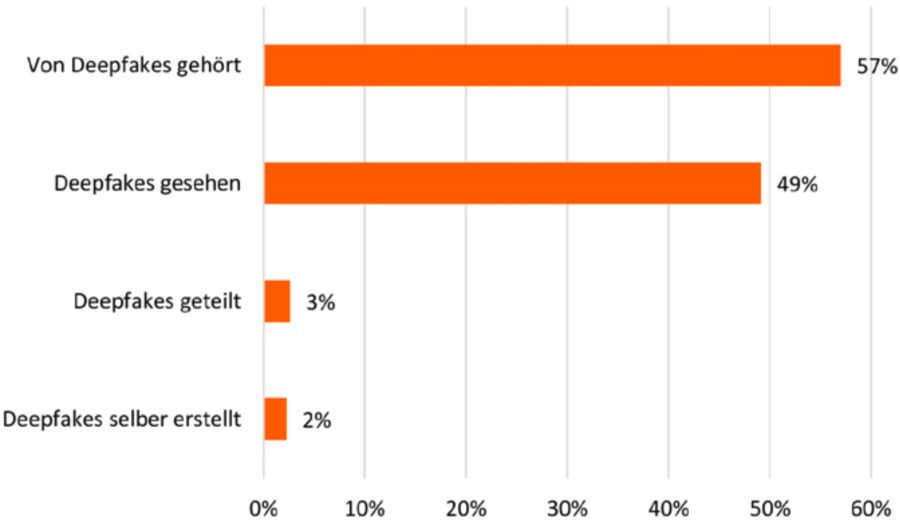

Daniel Vogler: Das war auch für uns überraschend. Klar kann man sagen: Ein Drittel kennt nicht einmal den Begriff «Deepfakes». Aber zwei Drittel eben schon, und dieser Anteil wird noch zunehmen.

Es hat keinen Sinn, die Technologie von der Bevölkerung fernzuhalten. So wird man auch damit vertraut.

Nau.ch: Andererseits scheitern sowohl Mensch wie Maschine grandios, wenn es darum geht, Deepfakes zu identifizieren. Unechtes wird nicht erkannt, Originale als Fälschung bezeichnet.

Daniel Vogler: Der Kontext ist natürlich ein wichtiger Anhaltspunkt. Aber rein visuell – ich selbst hatte keine Chance. Da überschätzt man sich!

Wenn man recherchiert, dann gelingt es eher, Deepfakes zu identifizieren. Aber ein Grossteil der Leute macht das wohl nicht. Vor allem, wenn die Aussage des Deepfakes ins eigene Weltbild passt.

Aktuell bereits problematisch sind Audio-Deepfakes. Mit solchen gelingt es Kriminellen schon heute, Leute zu täuschen und ihnen zum Beispiel vorzugaukeln, der Chef sei am Telefon.

Nau.ch: Genügen Information und die bereits angepasste Gesetzgebung, oder wo besteht noch Handlungsbedarf?

Daniel Vogler: Es ist natürlich sehr vielschichtig. Was man nicht will, ist ein Schnellschuss, mit dem man mit einem Schlag alles abdecken will. Was es sicher braucht, ist, dass man auch die bereits bestehende Gesetzgebung durchsetzt. Zum Beispiel bei Verletzung der Persönlichkeitsrechte.

Natürlich hinkt die rechtliche Entwicklung immer dem technischen Fortschritt hinterher. Das ist das Grundproblem. Deshalb ist es umso wichtiger, dass Bürgerinnen und Bürger befähigt sind, mit Deepfakes umzugehen.

Das tönt nach viel Pathos, aber ist enorm wichtig, gerade im Bildungsbereich. Fake News, Medienkompetenz, technische Kompetenz: Da muss man halt auch gesamtheitlicher denken.

Nau.ch: Ist der Zug nicht schon abgefahren? Es lässt sich wohl kaum mehr vermeiden, dass Deepfakes in der Gesellschaft Schaden anrichten werden.

Daniel Vogler: Persönlich würde ich sagen, wir sind noch nicht dort. Die Innovation schreitet zwar mit hohem Tempo voran. Aber: Im KI-Bereich sehen wir, dass auch nicht alles so funktioniert wie gedacht.

Gut, wir wissen nicht, wie es in fünf Jahren aussehen wird. Aber ich bleibe optimistisch.