Künstliche Intelligenz soll Co-Pilot werden

«Sind Sie schläfrig?», fragt der Computer. Der Pilot nickt und die Künstliche Intelligenz überträgt die Kontrolle dem Co-Piloten. Das soll bald möglich sein.

Das Wichtigste in Kürze

- Immer umfangreichere Assistenzsysteme nehmen Piloten im Cockpit einen Teil der Arbeit ab.

- Manchmal liefern sie aber so viele Informationen, dass Piloten oft überfordert sind.

- Ein KI-System mit Gesten- und Blick-Erkennung soll die Interaktion intuitiver machen.

Es ist Nacht, es stürmt, die Sichtverhältnisse sind mies. Eine Landung steht an. Die Instrumente im Cockpit blinken: Höhe, Geschwindigkeit, Neigung, Triebwerkzustand.

Auf den Piloten prasseln unzählige Informationen ein. Ist er müde, abgelenkt oder einfach überfordert, wird vielleicht schnell mal etwas übersehen – mit potenziell schwerwiegenden Folgen.

Moderne Assistenzsysteme im Cockpit sollen Piloten einen Teil ihrer Arbeit abnehmen. Paradoxerweise liefern diese Systeme aber in heiklen Situationen so viele Infos, dass Piloten oftmals überfordert sind.

Deshalb arbeiten Aviatik-Experten mit dem Schweizer Forschungszentrum CSEM daran, die Interaktion zwischen Mensch und Maschine im Cockpit zu verbessern. Peggasus heisst das Projekt, das das Leben von Piloten mit Hilfe von Künstliche Intelligenz erleichtern soll.

Künstliche Intelligenz soll Mensch nicht bevormunden

Beispielsweise soll der virtuelle Assistent die Piloten stets im Auge behalten und erkennen, ob sie müde, unkonzentriert oder verwirrt sind. Mithilfe einer Blickverfolgungs-Technologie der ETH Zürich merkt die Künstliche Intelligenz, ob ein Pilot in einer Situation die richtigen Instrumente ansieht.

Krallt sich der virtuelle Co-Pilot bei einem überforderten Kapitän einfach den Steuerknüppel? Nein, betont Andrea Dunbar von CSEM: «Das System soll den Piloten mental entlasten, damit er seinen Job richtig machen kann», sagt die Leiterin Embedded Systems. Es könne nicht einfach so die Kontrolle übernehmen. «Der Mensch hat immer das letzte Wort.»

Und wenn der Pilot bösartige Absichten hat? Wie der deutsche Co-Pilot, der im März 2015 eine Germanwings-Maschine bewusst in den französischen Alpen abstürzen liess. «Man könnte dem System beibringen, verdächtiges Verhalten zu erkennen. Es könnte dann den anderen Mitgliedern der Crew eine Warnung schicken», sagt Dunbar.

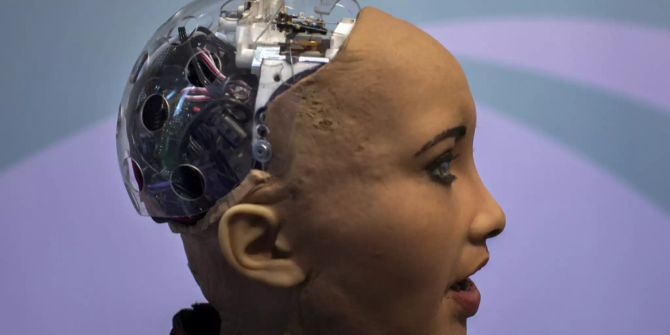

Mit unzähligen Fotos gefüttert

Damit die Künstliche Intelligenz Gemütszustände und Gesten identifizieren kann, muss sie den Menschen erst besser kennenlernen. Das geschieht mittels Deep Learning: Man füttert ihr unzählige Fotos von bestimmten Situationen, die sie dann Stück für Stück besser versteht. Mit der Zeit erkennt sie Gesten oder Gesichtsausdrücke auch in schlechten Lichtverhältnissen und aus verschiedenen Perspektiven. Das war für ältere Systeme unmöglich.

Ebenfalls wird die optimale Form der Interaktion gesucht: Wie soll das System eine Pilotin informieren, die in einer brenzligen Situation das falsche Panel anschaut? Und was ist die intuitivste Art für Piloten, auf das Computer-Feedback zu antworten? «Wisch-Bewegungen und Daumen hochstrecken sind Beispiele für natürliche Gesten. Sie sind effizient und ermöglichen es Piloten, sich auf Wichtigeres zu konzentrieren», sagt Andrea Dunbar.

Richtig spannend wird es in Kombination mit der Blickverfolgungs-Technologie: Dabei erkennt das System, welches Instrument die Pilotin gerade anschaut und weiss darum, worauf sich ihre Handbewegung bezieht.

*****

«Nau forscht»

Im Rahmen dieser Serie erscheint jeden Sonntag ein exklusiver Beitrag des Wissenschaftsmagazins «higgs».

Dieser Beitrag wurde verfasst von Roman Rey.