«Unumkehrbare Defekte»: KI lernt vermehrt von KI

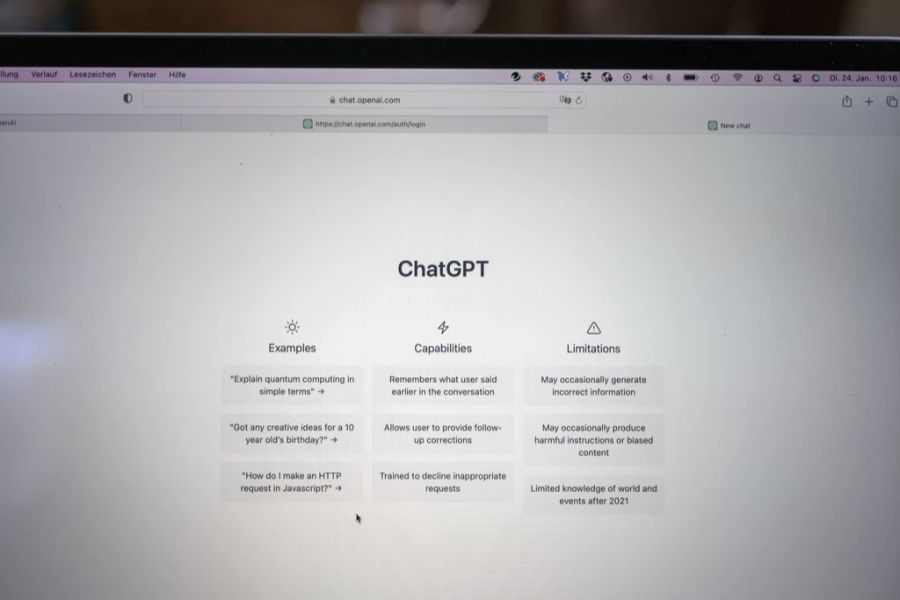

Eine neue Studie aus Grossbritannien beschäftigt sich der Frage, was es bedeutet, wenn ältere KI-Modelle Einfluss auf das Training neuerer Generationen nehmen.

Das Wichtigste in Kürze

- Britische Forscher widmen sich den Lernprozessen von KI-Sprachmodellen.

- Diese lernten künftig vermehrt von vorherigen KI-Generationen.

- Es sei davon auszugehen, dass sich dies negativ auf die Qualität der Inhalte auswirke.

Britischen Forschern zufolge sind von Menschen erstellte Datensätze essentiell für die Weiterentwicklung Künstlicher Intelligenz. Bislang beruhe das Training der heute prominentesten Sprachmodelle massgeblich auf solchen.

In Zukunft, so die Wissenschaftler der Universitäten Oxford, Cambridge und London, könne sich dies jedoch ändern. Mit möglicherweise fatalen Folgen.

Wie unter anderem das Online-Portal «Heise» berichtet, sehen die Autoren der Studie «Der Fluch der Rekursion» einen besorgniserregenden Trend. Nach diesem könnten KI-Anwendungen künftig vermehrt auf Basis vorheriger KI-generierter Texte trainiert werden. Nach mehreren solcher Verfahren könne der Bezug zum tatsächlichen Inhalt verlorengehen.

Zu viel «Blah» im Internet

Bereits jetzt, so die Wissenschaftler, werde das Internet durch KI-Anwendungen «mit Blah gefüllt». Dies wirke sich unweigerlich auf die Lernprozesse kommender KI-Generationen aus. Letztlich sei davon auszugehen, dass dies zu «unumkehrbaren Defekten» führe, die derart trainierte, neue Modelle kollabieren liessen.

Einen Weg zum Umgang mit der Problematik sehen die Wissenschaftler darin, sicherzustellen, dass der Zugang zur ursprünglichen Datenquelle erhalten bleibt. Zudem raten sie dazu, KI-generierte Datensätze nach Möglichkeit von menschengemachten unterscheidbar zu halten.