Wollen wir Googles Hasskommentar-Filter?

Eine neue Google-Software blendet giftige Reaktionen auf sozialen Medien aus. Einer gesunden Meinungsbildung ist das gemäss Experten aber nicht förderlich.

Das Wichtigste in Kürze

- Auf vielen Online-Plattformen herrscht eine giftige Diskussionskultur.

- Mit einem neuen Google-Programm kann man gehässige Kommentare einfach herausfiltern.

- Laut Experten beeinträchtigt das jedoch die Meinungsbildung.

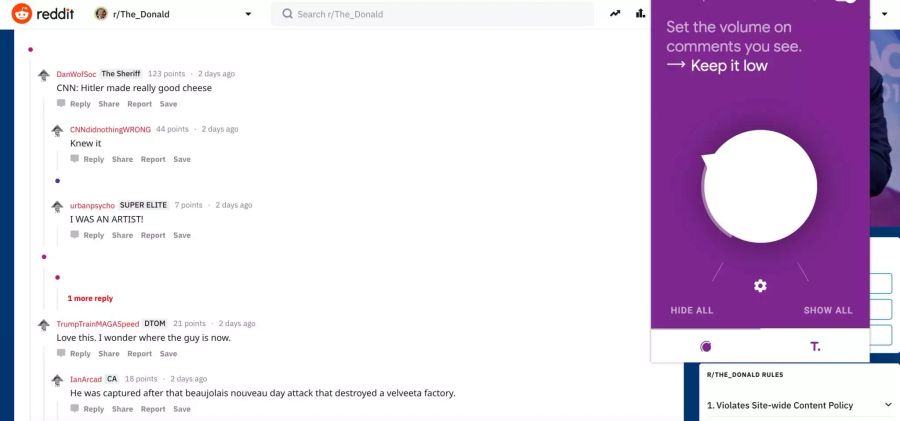

«Halts Maul!», «Du hast den IQ von einem Weggli!»: Im Internet wimmelt es von gehässigen Kommentaren. Das kann dem geneigten Nutzer schnell mal den Tag vermiesen.

Ein Programm des Google-Partners Jigsaw soll nun Abhilfe schaffen. Mit der Browser-Erweiterung Tune lassen sich Kommentare aus grossen Plattformen wie Facebook, Twitter oder Youtube einfach ausblenden. Der Algorithmus, der bisher nur auf Englisch funktioniert, ist laut dem Google-Partner noch in seiner experimentellen Phase.

Google-Filter nicht nur positiv

Doch soll man sich das Internet wirklich schön filtern? Lilian Suter, wissenschaftliche Mitarbeiterin der Fachgruppe Medienpsychologie an der ZHAW, ist skeptisch. «Wer alles Negative herausfiltert, läuft Gefahr, im eigenen Weltbild gefangen zu sein», sagt Suter. «Die Meinungsbildung braucht Pro- und Kontra-Argumente.»

Ein freundlicheres Internet sei zwar wünschenswert, aber man bekämpfe mit solchen Massnahmen nur Symptome. «Besser als Ausblenden ist es, sich Medienkompetenz anzueignen», sagt Suter. Dazu gehöre etwa, giftige Aussagen relativieren zu können. «Man sollte sich bewusst werden, dass solche Kommentatoren oft nicht die Mehrheit repräsentieren, auch wenn es den Eindruck erweckt.»

Auf Hasskommentare aufmerksam machen

Diesen Weg schlägt die «alliance F» ein, der Dachverband der Schweizer Frauenorganisationen. Die Organisation entwickelte im Rahmen des Projekts «Stop Hate Speech» einen Algorithmus. Der soll Hasskommentare auf sozialen Medien und in den Kommentarspalten von Schweizer Online-Medien aufspüren. Eine Community soll so darauf aufmerksam gemacht werden, um sich einschalten und dem Hass entgegenwirken zu können.

Auf Automatismen, die Kommentare sperren oder direkt an die Staatsanwaltschaft weiterleiten, will die «alliance F» verzichten. «Hate Speech ist kein technisches, sondern ein menschliches Problem», sagt Geschäftsführerin Sophie Achermann zu «higgs». «Und dort wollen wir ansetzen, wir wollen die Medienkompetenz fördern».

Schweizer Medien offen für Automatismen

Im Spätsommer soll die Plattform mit einem lernenden Algorithmus online gehen. Eine möglichst vielfältige Gruppe von Freiwilligen wird dann Kommentare bewerten und der Software beibringen, worauf sie achten soll.

Die Software Perspective, auf der die Google-Browser-Erweiterung basiert, ist bei grossen Medien wie der New York Times im Einsatz. Dort unterstützt es die Community-Teams dabei, Kommentare zur Sperrung zu selektionieren.

Auch in der Schweiz gibt es bereits technologische Lösungen, erklärt Tamedia-Sprecherin Nicole Bänniger. «Bei erfahrungsgemäss weniger heiklen Themen setzt ‹20 Minuten› einen semantischen Computer ein, der nach gewissen Begriffen sucht», so Bänniger. Bei einem Treffer würde der entsprechende Kommentar automatisch gelöscht.

Weniger Automatismen bei heikle Themen

Bei potentiell heiklen Themen wird noch von Hand freigeschaltet. Beim Online-Medium werden laut Bänninger täglich bis zu 15’000 Leserkommentare geschrieben, von denen zwei Drittel publiziert werden.

Auch beim «Blick» werden jeden Tag etwa 2000 Kommentare geschrieben. Deswegen ist von 7 bis 23 Uhr ein Team im Einsatz, das Beiträge von Hand freischaltet, sagt Ringier-Sprecher Manuel Bucher.

«Eine Lösung mit Algorithmen, die unser Team bei der Moderation unterstützen, ist eine Möglichkeit, die wir verfolgen», so Bucher. «Allerdings wird es immer Kommentare geben, bei denen ein Mensch entscheiden muss, ob sie freigeschaltet werden oder nicht.»

*****

«Nau forscht»

Im Rahmen dieser Serie erscheint jeden Sonntag ein exklusiver Beitrag des Wissenschaftsmagazins «higgs».

Dieser Beitrag wurde verfasst von Roman Rey.