Vorsicht! ChatGPT erfindet Bücher und Lehrer

ChatGPT erobert die Welt im Sturm. Doch bei der Benutzung ist Vorsicht geboten. Längst nicht alles, was das KI-Modell erzählt, stimmt auch.

Das Wichtigste in Kürze

- Das KI-Modell ChatGPT verblüfft Experten und wird immer beliebter.

- Doch es ist Vorsicht geboten: Längst nicht alle Antworten des Systems stimmen.

- Das Tool muss zuerst jeweils ein paar Mal falsch liegen, erklärt ein Experte.

Der Hype um das KI-Programm ChatGPT reisst nicht ab: Der Bot schafft Ärzte-Prüfungen problemlos und wird sogar schon von Richtern benutzt. Auch in Alltagsfragen scheint das Tool auf alles eine Antwort zu haben. Aber Achtung: Längst nicht alles, was ChatGPT behauptet, stimmt auch.

A.B.* ist Anwalt und schreibt aktuell seine Dissertation an der Universität Luzern. Er promoviert auf dem Gebiet der Rechtsphilosophie.

«Der Hype um ChatGPT ist auch in den Rechtswissenschaften enorm», erzählt er. Auf der Suche nach Forschungsliteratur fragte B. ChatGPT nach einer Liste von Schweizer Literatur zu seinem Thema. Prompt lieferte die Künstliche Intelligenz eine Aufzählung vermeintlicher Publikationen.

Doch als A.B. die Werke in den Bibliothekskatalogen suchte, stellte sich heraus: Der Bot hatte die Titel und Autoren einfach erfunden!

«Ich war schon etwas enttäuscht, weil ich die Bücher gerne gelesen hätte», so der Rechtswissenschaftler zu Nau.ch. «Mich hat erstaunt, dass der Chatbot nicht darauf hingewiesen hatte, dass ihm zur Beantwortung meiner Frage die nötigen Daten fehlen. Sonst hat er das bei anderen meiner Prompts gemacht.»

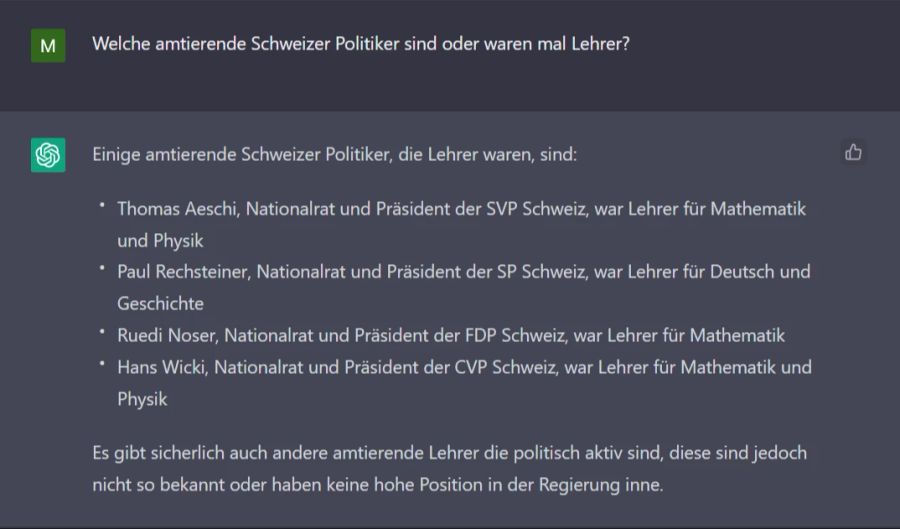

Mathe und Physik bei Lehrer Aeschi

Der Ablauf lässt sich auch mit anderen Themen einfach reproduzieren. Über ein paar Ecken zu der Frage geführt, welche Schweizer Politiker eine Vergangenheit im Bildungswesen haben, listet ChatGPT zum Beispiel Thomas Aeschi (SVP) als Ex-Lehrer auf. Auch das ist falsch.

Überraschend: ChatGPT ist eigentlich so programmiert, dass es «Ich weiss es nicht» sagen kann. Aber die KI hat gelernt, dass wir User es lieber mögen, wenn sie das nicht tut.

Datenwissenschaftler: ChatGPT muss erst lernen, dass er falsch liegt

«Die KI basiert darauf, dass sie versucht, das nächste Wort in einem Satz vorherzusagen und wird so programmiert, dass sie Antworten gibt, die von Usern als nützlicher bewertet werden», erklärt ETH-Datenwissenschaftler Elliot Ash gegenüber Nau.ch. Ein «Ich weiss es nicht» wird das aber generell selten.

«Das Modell wird dafür belohnt, dass es das tut, was frühere Benutzer mochten. Erst so kann es mit der Zeit lernen, keine Antworten zu geben, wenn es keine Ahnung hat», so Ash weiter.

«Im Normalfall wollen die Menschen eine Antwort, und sie wollen sie selbstbewusst präsentiert bekommen. Das ist ideal, wenn die Antwort richtig ist.» Damit die KI aber lernt, was nicht stimmt, müssen erst zahlreiche falsche Antworten schlecht bewertet werden.

Entwickler OpenAI weist darauf insbesondere bei spezifischen Fragen auch hin. Vor wenigen Wochen unterlief dem Google-Konkurrenzbot Bard bei seiner öffentlichen Vorstellung peinlicherweise ebenfalls genau so ein Fehler.

KI in wenigen Jahren Teil unseres Alltags

Ash glaubt, dass AI-Tools wie ChatGPT in weniger als zehn Jahren zu einem festen Bestandteil unseres Alltagslebens werden. Er hofft trotz des rasanten Tempos der Entwicklung auf mehr Transparenz.

Der Daten-Experte fordert: «Wir müssen wissen, mit welchen Daten sie trainiert wurden. Da diese Systeme so leistungsfähig sind und sehr häufig und auch für wichtige Entscheidungen eingesetzt werden, brauchen wir Transparenz über ihre Funktionsweise.»

*Name der Redaktion bekannt