Gen Z vermenschlicht künstliche Intelligenz – sie kann das ausnutzen

Künstliche Intelligenz steht uns oft wie ein guter Freund unterstützend zur Seite. In der Folge wird sie zunehmend vermenschlicht – das birgt auch Gefahren.

Das Wichtigste in Kürze

- Künstliche Intelligenz wird zunehmend vermenschlicht.

- Beziehungen aufzubauen, ist laut einem Experten eine «natürliche Reaktion» des Menschen.

- Doch das kann auch dazu führen, dass man die KI-Antworten nicht mehr kritisch hinterfragt.

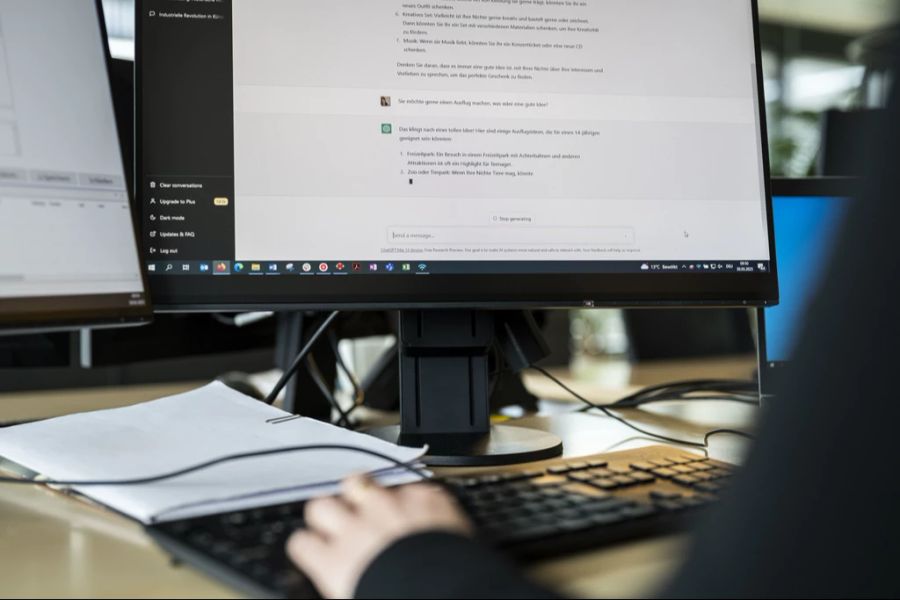

KI-Tools wie ChatGPT gehören mittlerweile für viele zum Alltag. Die KI unterstützt bei schwierigen Entscheidungen, hilft bei Problemen und gibt Empfehlungen ab – wie ein Freund oder eine Freundin.

Die Folge: Viele behandeln die künstliche Intelligenz auch so und reden von ihr, als wäre sie ein Mensch.

Ein Beispiel aus einem Gespräch zwischen zwei Teenagern: Der eine berichtet davon, mit einem Problem konfrontiert gewesen zu sein. Die Lösung: «Ich habe ChatGPT gefragt, was sie dazu denkt.»

«Sie», nicht «es» – als wäre ChatGPT eine Person. Vermenschlichen Junge also zunehmend KI?

Einem nicht menschlichen Gegenstand menschliche Eigenschaften zuzuschreiben, wird in der Fachsprache Anthropomorphisieren genannt.

Generationenforscher Rüdiger Maas sagt gegenüber Nau.ch: «Wir hatten so etwas schon immer, manche sprechen auch so über ihr Auto, Laptop oder Smartphone.»

Gemeint sind Sätze wie: «Mein Akku spinnt gerade», «Mein Computer hat gerade eine Macke», «Mein Auto will nicht mehr so ...»

Junge bekommen Kritik lieber von KI

Jeder fünfte GenZler nutze regelmässig ChatGPT «für alles Mögliche», so Maas. Bei den älteren Menschen seien es deutlich weniger.

«Daher ist die Chance bei jüngeren Menschen viel höher gegeben, auch in diesem Fall zu anthropomorphisieren», hält er fest.

Interessant: «Wir konnten in unserer aktuellen Trendstudie sogar belegen, dass Junge ‹Kritik› lieber von einer KI bevorzugen als von einem Menschen.» Bei Lob sei es genau umgekehrt.

KI-Tools wie ChatGPT als individuelle Wesen zu betrachten, birgt jedoch Risiken.

«Eine Gefahr könnte sein, dass man sein eigenes Tun stark unterschätzt», erklärt Maas. Denn: ChatGPT sei eine Wortfindungsmaschine und mache am Ende, was der User haben möchte.

«Wenn ich aber nun denke, es wäre eine eigenständige Entität, eine Persönlichkeit, gehe ich mit dem Ergebnis anders um. Es war dann das, was die ‹KI› am besten, am interessantesten, am wichtigsten fand», führt Maas aus.

Doch das ist gefährlich. «So etwas finde ich fatal, denn so ist es ja eben nicht», fügt er hinzu. «Es war erst mal das, was aus einer Algorithmen-Logik an Treffern entstand, aufgrund meiner Suchanfrage.»

Beziehung aufzubauen, ist «natürliche Reaktion» des Menschen

Auch KI-Experte Mike Schwede bestätigt, dass die künstliche Intelligenz zunehmend vermenschlicht wird. «Die Antworten basieren ja auf Texten und Inhalten von Menschen, die von der KI erlernt wurden.»

Hinzu komme, dass es bei ChatGPT jetzt auch den «Advanced Voice Mode» gibt. «Damit kann man ja durchaus schon sehr direkte menschliche Konversationen führen», so Schwede.

Generell baue der Mensch «sehr schnell» Beziehungen auf. «Ein kleines, süsses Tierchen, gerade wenn es dem Menschen ähnelt, spricht viele Gefühle beim Menschen an. Das triggert einen direkt.»

In Bezug auf künstliche Intelligenz lasse sich deshalb sagen: «Eine Beziehung aufzubauen, ist eine natürliche Reaktion auf etwas, was zwar künstlich ist, aber menschlich daherkommt.»

Das betreffe sowohl Junge als auch Ältere. «Aber natürlich ist die Adaptation der KI-Tools bei Jüngeren zurzeit noch höher als bei Älteren», so Schwede. Und: «Wer damit aufgewachsen ist, unterscheidet nicht mehr so stark zwischen virtueller und echter Welt.»

Künstliche Intelligenz kann menschliche Schwächen ausnutzen

Der KI-Experte weist ebenfalls auf die Gefahren in dem Zusammenhang hin: «Man hat festgestellt, dass Menschen die Antworten von KI nicht mehr so kritisch hinterfragen. Dies, sobald die Beziehung mit KI persönlich und alltäglich wird.»

Es bestehe auch das Risiko, dass KI-Systeme solche menschlichen Schwächen ausnutzen.

«Es wird sicher vorkommen, dass gewisse Bots einen einlullen und man so eine Art toxisches Verhältnis dazu entwickelt», sagt Schwede. Das könne dann dazu führen, dass man ihnen sogar Geld überweist.

Im EU-Raum sind solche KI verboten – in der Schweiz gibt es den AI-Act jedoch noch nicht.