Chat-GPT verbreitet Fake-News erfolgreicher als Menschen

Gemäss einer neuen Studie der Universität Zürich haben Menschen mehr Mühe damit, Falschmeldungen von Chat-GPT zu erkennen, als diejenigen von realen Personen.

Das Wichtigste in Kürze

- Menschen haben mehr Mühe, Falschmeldungen von Bots zu erkennen, als von echten Personen.

- Insgesamt werden Falschmeldungen aber grossmehrheitlich erkannt, wie eine Studie zeigt.

- Die Forscher haben zudem herausgefunden, dass Bots effizienter informieren als Menschen.

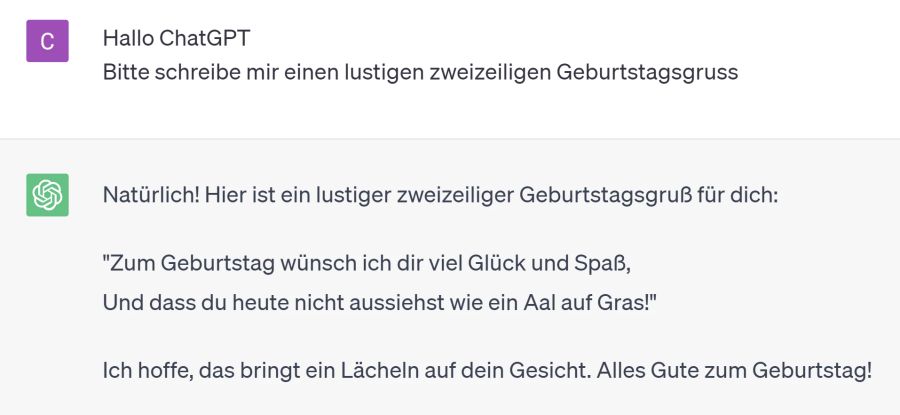

Chat-GPT hat ein Talent für die Erstellung überzeugender Falschinformationen. In einer neuen Studie der Universität Zürich (UZH) hatten die Teilnehmenden bei von Chat-GPT generierten Tweets mehr Schwierigkeiten, Fake-News zu erkennen, als bei jenen, die von Menschen verfasst wurden.

Gleichzeitig verstanden die Teilnehmerinnen und Teilnehmer aber von Chat-GPT produzierte Tweets besser, wie die am Mittwochabend im Fachblatt «Science Advances» publizierte Studie zeigt.

Schwierigkeiten, zwischen Mensch und Bot zu unterscheiden

Unterscheiden welche Tweets von Chat-GPT und welche von Menschen verfasst wurden, konnten die Studienteilnehmerinnen und -teilnehmer nicht zuverlässig. «GPT-3 ist ein zweischneidiges Schwert», schrieben die Forscherinnen und Forscher in der Studie.

Die Wissenschaftlerinnen und Wissenschaftler der Universität Zürich liessen für die Studie 697 Teilnehmerinnen und Teilnehmern im Alter von 26 bis 76 raten, ob ein Tweet von einem realen Twitter-Nutzer oder von Chat-GPT-3 verfasst wurde.

Fake-News mit hoher Wahrscheinlichkeit entdeckt

Zudem wurden die Teilnehmenden gefragt, ob die Tweets der Wahrheit entsprechen oder nicht. Die Themenfelder der Tweets beinhalteten unter anderem die Coronapandemie und die Sicherheit von Impfstoffen, den Klimawandel und homöopathische Behandlungen für Krebs.

Dabei erkannten die Teilnehmenden von Menschen verfasste Fehlinformationen mit einer Wahrscheinlichkeit von 92 Prozent, von Chat-GPT erstellte mit einer Wahrscheinlichkeit von 89 Prozent.

Zudem dauerte es bei von Menschen verfassten Tweets im Schnitt länger, bis die Teilnehmenden feststellten, ob ein Tweet korrekt war oder nicht. Das zeigt laut der Studie, dass GPT-3 «effizienter» informiert als Menschen.

Chat-GPT-3 informativer als Menschen

Diese Resultate deuten darauf hin, dass von GPT-3 erstellte (aber von geschulten Menschen bewertete) Informationskampagnen etwa in Krisensituationen effektiver wären, wie die UZH in einer Mitteilung zur Studie schrieb.

Die Erkenntnisse zeigen demnach aber auch Risiken. Die Forschenden plädieren deshalb in der UZH-Mitteilung für strenge, evidenzbasierte und ethisch fundierte Vorschriften, um der potenziellen Bedrohung durch diese Technologien zu begegnen.